Dans le débat autour de la reconnaissance faciale automatique, l’alternative semble être soit de bannir la technologie soit de réglementer son utilisation. En commentant l’Affaire Bridges (2020), Connal Parsley & Conor Heaney montrent les limites de cette alternative. L’article est traduit par Solène Semichon.

Introduction

C’est dans l’affaire R (on the application of Bridges) c Chief Constable of South Wales Police1 (« Bridges ») que, pour la première fois, une cour du Royaume-Uni a examiné l’utilisation de la technologie de reconnaissance faciale automatique (RFA) par la police. Cet article propose un commentaire de cette décision s’appuyant sur la critique récente du « cadre juridique [de la RFA] et de son interprétation par les cours britanniques », dont on dit qu’ils transforment « la protection des droits humains en un exercice de cases à cocher, empêchant un débat politique important sur les conséquences normatives de la surveillance de type RFA par la police2 ». Nous défendons la thèse selon laquelle on devrait moins lire cette affaire pour la réponse qu’elle donne à la question de savoir si la RFA peut-être « en accord avec la loi », et comment, que comme une démonstration de la capacité limitée de cette question elle-même – et du cadre légaliste libéral à laquelle elle appartient – à limiter la perturbation politico-normative créée par les technologies algorithmiques, et en particulier par la RFA. Notre objectif est d’étendre les critiques bien connues de la vision politique du légalisme politique et des approches fondées sur la défense des droits individuels. Par « légalisme libéral », nous entendons la conjonction de plusieurs idées dominantes – bien que souvent latentes – du droit, fondées sur la philosophie politique du libéralisme3. En voici trois : que la « légalité » est libre de valeurs politiques fondamentales et qu’elle a donc autorité pour arbitrer ces valeurs4, que le droit (et ses processus, raison et logique formels) est le moyen le meilleur et le plus désirable pour aborder des problèmes politiques et sociaux5, et l’humanisme libéral, qui considère le « sens historique et juridique6 » comme un produit de la réflexion critique qui prend « l’humain », idée assez abstraite et censément universelle7, comme le sujet et la fin appropriés du raisonnement et des procédés juridiques.

Notre lecture de l’affaire Bridges selon la perspective des limites du légalisme libéral quand il rencontre la technologie algorithmique de la RFA s’inspire de deux grands courants de la littérature. Le premier est la tradition interdisciplinaire des études juridiques critiques, et particulier son rejet analytique de la stricte séparation entre droit et politiques, et sa compréhension du droit comme structurant la communauté politique, affectant la texture fondamentale de la co-appartenance8. Le deuxième courant est cette vague de la littérature des études du droit et de la technologie qui comprend les technologies fondées sur les données (dont le code est le vecteur) comme hétérogènes à la normativité des systèmes juridiques libéraux et à l’état de droit (dont le droit s’entend comme fondé sur les textes et l’herméneutique9). Cette littérature considère que ces technologies perturbent la fonction du droit qui consiste à préserver une communauté politique démocratique. Gardant ces traditions à l’esprit, nous lisons Bridges afin de répondre à deux questions : d’abord, jusqu’à quel point les affaires s’appuyant sur les cadres réglementaires du légalisme libéral remettent-elles en question les effets des nouvelles technologies numériques sur la texture politique de la vie ? Si Bridges montre que l’on peut ramener l’utilisation de la RFA par la police à l’intérieur des paramètres de légalité, nous soutenons que ces derniers n’interagissent avec l’effet de la RFA sur le public et sur l’espace public que de façon limitée. Ensuite, quel est l’effet politique ou la capacité d’action des cadres normatifs du libéralisme juridique eux-mêmes quand ils sont adoptés pour régir l’utilisation des technologies algorithmiques comme la RFA ? Nous avançons qu’en normalisant et en légitimant la RFA ces cadres préservent les critères de la légalité mais technicisent les processus juridiques d’une façon qui perturbe la communauté politique plutôt qu’elle ne la préserve. Il s’agit là d’une inversion du récit traditionnel du système juridique compris comme conservant cette communauté grâce à la priorité qu’il donne au « nomos » humain sur la « physis » matérielle, comme protégeant l’humain10 en tant que forme morale et politique de vie11 précisément par opposition au contrôle de la technologie12. Nous reconnaissons la valeur, même limitée, des cadres juridiques actuels – suivant en cela l’affirmation de Sun-ha Hong que « la vie privée et l’humanisme sont nécessaires mais insuffisants13 ». Nous suggérons cependant qu’il faudrait prendre cette insuffisance bien plus au sérieux. Bridges devrait conduire les juristes comme les spécialistes de la technologie critique à étudier de façon urgente le besoin de cadres normatifs différents pour évaluer la RFA. Nous affirmons également que les approches technosociales offrent un bon point de départ pour la tâche assurément difficile de négocier ces cadres.

Dans une deuxième partie, nous introduirons la décision Bridges et nous identifierons certains aspects particuliers de cette affaire. Nous examinerons ensuite les limites de l’affaire qui utilise les cadres des droits juridiques libéraux, en ajoutant des détails analytiques importants et en identifiant deux limites centrales : son épistémologie limitée de la technologie et sa restriction de la considération normative de la communauté politique pour les intérêts de laquelle la RFA est censée être déployée. Dans la quatrième partie, nous nous tournerons vers les approches de la recherche technosociale comme point de départ de la négociation de cadres normatifs alternatifs. Après avoir brièvement présenté la pensée des philosophes français Gilbert Simondon et Bernard Stiegler, nous soulignerons le besoin que la théorie juridique a de développer les découvertes de leur travail de façons pratiques, imaginatives et pluridisciplinaires. Nous conclurons en soulignant comment la conception du projet de recherche UKRI-funded Future of Good Decisions le fait, y compris par l’utilisation de méthodes de recherche préfiguratives, afin de construire une conception et des pratiques d’évaluation participatives.

R (Bridges) : Une affaire tout à fait inhabituelle

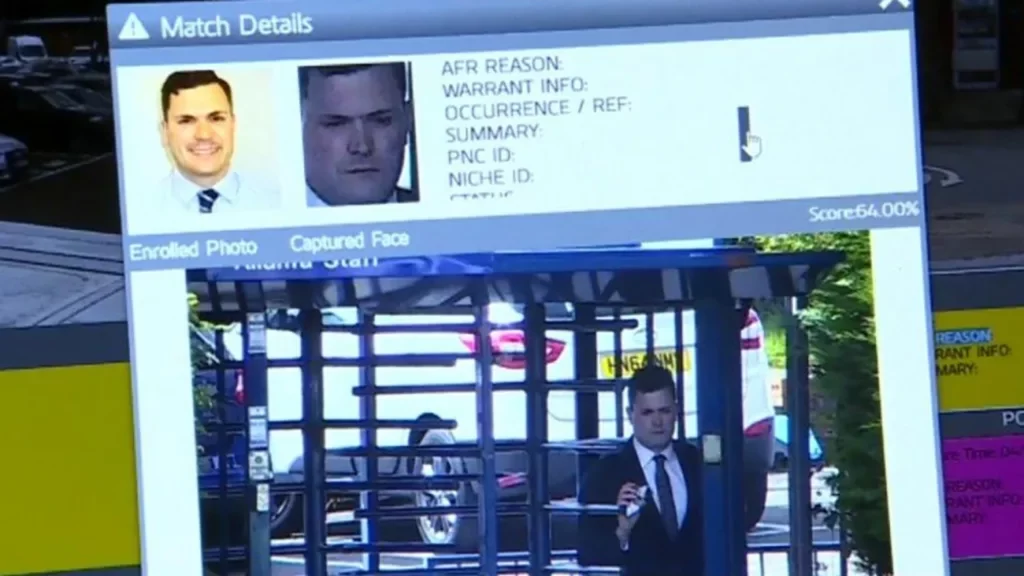

L’affaire Bridges est née de l’utilisation de la RFA par la police du sud du pays de Galles (South Wales Police Force (« SWP, »)) qui a joué le rôle de testeur national lors d’un essai de la technologie au Royaume-Uni. La SWP a adopté un système appelé AFR Locate, outil d’appariement d’images qui compare les données biométriques extraites d’images numériques de visages provenant de la surveillance automatique en direct à des images d’une base de données préexistante. On peut diviser son utilisation en six éléments : la compilation d’une base de données d’images existantes, l’acquisition d’images en direct au rythme d’environ 50 visages par seconde, la détection des visages, l’extraction des traits menant à la création d’un modèle biométrique pour chaque visage, la comparaison avec les images de la base de données et la production d’un « score de similitude » qui donne lieu à une « correspondance » si un seuil prédéterminé de similitude est atteint. La SWP a déployé AFR Locate d’une façon non cachée lors d’à peu près 50 événements publics importants, en utilisant des caméras de vidéosurveillance montées sur des véhicules de police. Les images ainsi capturées étaient traitées en temps réel et comparées avec des images de « listes de surveillance » préparées pour chaque déploiement. S’il n’y avait pas de « correspondance », les données biométriques directes étaient « immédiatement et automatiquement effacées14 ». S’il y avait une correspondance, l’officier de police pilotant le système contrôlait manuellement les images, décidant si la correspondance en était une, et s’il fallait en avertir les officiers à proximité, ce qui pouvait donner lieu à une approche du sujet ou même à son arrestation.

Le demandeur dans cette affaire était Edward Bridges, militant pour les droits civiques soutenu par Liberty, organisation bien connue œuvrant en faveur des droits civiques. Bridges pensait qu’il avait été filmé par une caméra à deux moments particuliers. Il prétendait ne pas avoir vu la signalisation ou les avertissements sur l’utilisation de la RFA avant de se trouver à proximité de cette dernière, ce que la Cour a trouvé raisonnable, malgré les démarches effectuées par la SWP pour informer le public du déploiement de AFR Locate à l’avance, par des publications sur les réseaux sociaux, sur le site internet de la SWP et par des affiches de taille A2 et des prospectus sur place. Il est important de noter que s’il y avait eu certains exemples de « faux positifs » lors d’un déploiement, ainsi que certains vrais positifs et arrestations, ce n’était cependant pas le sujet de la demande de Bridges : il n’avait eu aucune interaction avec les policiers, par conséquent, s’il avait effectivement été filmé, son image aurait été « immédiatement et automatiquement » effacée. Bridges demandait l’examen par la Cour de la légalité de l’utilisation de la RFA par la SWP. Sa requête fut rejetée par la Cour du Banc de la Reine en formation d’appel15, mais la Cour d’appel cassa cette décision. Comme nous l’expliquons ci-dessous, elle estima que l’utilisation de la RFA par la SWP violait les droits à la vie privée, les lois sur la protection des données et celles sur l’égalité.

Il y a trois éléments inhabituels dans cette affaire. D’abord, il est frappant qu’il n’ait pas été possible d’un point de vue technique de savoir si l’image de Bridges avait été capturée par AFR Locate. On ne demanda en effet même pas à Bridges de prouver qu’il était présent aux deux déploiements qui faisaient l’objet de sa demande. Si l’on prend en compte que Liberty, ainsi que 31 autres organisations de la société civile, ont co-signé une lettre ouverte affirmant « nous ne croyons pas que la [technologie de reconnaissance faciale en direct] puisse jamais être déployée en toute sécurité dans l’espace public16 », on peut interpréter cette affaire comme une tentative d’aborder ce que nous pourrions appeler les effets généraux, « atmosphériques », de la RFA sur le public, et comme ne servant que secondairement à la réparation d’un dommage individuel subi par Bridges. Le fondement de l’affaire en droits humains et protection des données transforma une inquiétude sur la vie publique en problème de vie privée et de vie de famille, ce qui nous mène au deuxième élément frappant de l’affaire, à savoir, sa nature consensuelle et même collaborative. Pour des « raisons pragmatiques », la SWP ne contesta pas l’intérêt que Bridges avait d’introduire une demande de contrôle juridictionnel, mais accepta le fait qu’il ait été une « victime17 » de l’acte d’un pouvoir public en vertu du paragraphe 7 de la loi de 1998 sur les droits humains (Human Rights Act (« HRA »)), qui intègre les dispositions de la Convention européenne des droits de l’homme (ConvEDH) dans le droit britannique). Cette affaire fut en effet annoncée comme « une tentative de s’assurer dès le début des conseils de la Cour sur le cadre et les paramètres juridiques relatifs à la RFA, tant que cette dernière n’était encore qu’en phase d’essai et avant qu’elle ne soit déployée au niveau national », la Cour de première instance notant « la façon collaborative et utile dont l’affaire a été présentée par toutes les parties impliquées18 ». De même, ces dernières s’accordèrent pour traiter l’affaire comme si la loi sur la protection des données (Data Protection Act (2018) (« DPA 2018 »)) avait été en vigueur au moment des déploiements en question (en 2017 et au début de 2018) afin que les conclusions de la Cour s’appliquent à des utilisations futures de la RFA, ce qui annonce le troisième aspect particulier de l’affaire Bridges : l’importance pratique de la décision. Il y eut initialement des interprétations très différentes de son sens. Soulignant la conclusion de non-respect de la loi, Liberty présenta cette décision comme « une victoire majeure dans la lutte contre la RFA, facteur de discrimination et d’oppression19 », suggérant qu’elle « voulait dire que la police utilisant la reconnaissance faciale dans les rues du Royaume-Uni doit arrêter son essai qui dure depuis longtemps20 ». La SWP répondit cependant, et avec raison, en montrant que rien dans le jugement de la Cour d’appel n’« empêchait l’utilisation [de la RFA] pour protéger le public21 », et en clarifiant son intention de le faire au nom de la sécurité de ce dernier.

Bridges fit appel du rejet de sa demande en invoquant cinq motifs. Trois de ces motifs furent acceptés et deux refusés, mais les façons dont ces derniers le furent sont importantes pour notre analyse, les premiers montrant également les limites politiques et normatives de ce cadre juridique. Pour les besoins de cet article, nous allons examiner les motifs 1, 3 et 5.

Le premier motif, qui fut accepté, concernait l’extraction par AFR Locate de données biométriques dont Bridges soutenait qu’elle violait l’article 8 de la CEDH concernant le respect de la vie privée et de la vie de famille. L’appel considéra le cadre juridique entourant le déploiement d’AFR Locate, dont la DPA, une version actualisée du Code de pratique de la surveillance vidéo (Surveillance Camera Code of Practice) dépendant de la loi sur la protection des libertés (Protection of Freedoms Act) de 2012, les directives de la police, et la Politique sur le traitement des données sensibles à des fins de maintien de l’ordre (Policy on Sensitive Processing for Law Enforcement Purposes). La Cour considéra que si le cadre réglementant le déploiement de la RFA permettait l’examen de la proportionnalité de son utilisation (concernant les fins de maintien de l’ordre en vertu de la DPA de 2018), le pouvoir discrétionnaire de la SWP de choisir qui pouvait apparaître sur une liste de surveillance, et où la RFA pouvait être déployée était trop important. Le cadre juridique n’avait donc pas les « qualités nécessaires du droit22 ».

Le deuxième motif, qui fut rejeté, affirmait que toute évaluation de la proportionnalité en vertu de l’article 8(2) de la ConvEDH devrait prendre en compte l’effet cumulatif de toute violation des droits de ceux présents à l’événement public – selon nous une autre tentative claire d’utiliser cette affaire pour aborder la question de l’effet de la RFA sur le public. Même si la Cour n’avait pas besoin d’examiner la proportionnalité (puisque l’utilisation de la RFA était considérée comme une violation de l’article 8), elle affirma néanmoins qu’un équilibre juste avait été trouvé « entre les droits de l’individu et les intérêts de la communauté », et que l’impact de Bridges était « négligeable » et ne devait pas être « multiplié » par le nombre de personnes impliquées. C’était là, dirent les juges, une question de « jugement » plutôt que de « multiplication23 ».

Le cinquième motif concernait la question de savoir jusqu’à quel point et grâce à quelles méthodes la SWP respectait son devoir d’égalité dans le secteur public (Public Sector Equality Duty) selon le paragraphe 149(1) de la loi sur l’égalité (Equality Act) de 2010, en examinant le risque de discrimination indirecte dans l’utilisation d’une technologie algorithmique. Même s’il n’y avait pas de suggestion de biais « réel » dans le fonctionnement de AFR Locate, la Cour d’appel jugea que la SWP n’avait jamais essayé de vérifier que ce logiciel ne contenait aucun biais de sexe ou de race potentiel et inacceptable quand on l’utilisait24. La Cour de première instance avait considéré que la « sécurité humaine intégrée » par la vérification manuelle d’une image était suffisante, mais la Cour d’appel ne fut pas d’accord et montra les limites des facteurs humains subjectifs et le fait que la SWP aurait pu faire davantage, qu’elle aurait pu, en particulier, étudier la « composition démographique » des ensembles de données d’entraînement utilisés pour créer AFR Locate25. NeoFace, le logiciel, est pourtant un produit breveté, d’une entreprise privée.

La Cour accorda un « jugement déclaratif » affirmant que l’utilisation d’AFR Locate par la SWP n’était « pas conforme à la loi », selon l’article 8 de la CEDH, le paragraphe 64 de la DPIA, et le paragraphe 149 de la loi sur l’égalité (Equality Act). Depuis cette décision, les commentaires ont souligné le fait que loin de mettre un terme à l’utilisation de la RFA, « la décision ouvre la voie à une expansion de la RFA à l’intérieur d’un cadre légal défini26 ». Les commentaires juridiques se sont pour la plupart concentrés sur la façon dont la police peut respecter les paramètres posés dans la décision, y compris en appelant à légiférer27 afin d’augmenter le degré de certitude. Au-delà d’ajustements mineurs aux pratiques de la police et aux cadres de déploiement, cela pose des problèmes pratiques et techniques qui se retrouvent aussi dans la science critique des données, en particulier la question de savoir comment exactement évaluer les ensembles de données d’entraînement dans les logiciels brevetés28. Il y a cependant certains signes qui montrent que nous allons voir l’introduction de nouveaux documents sur le devoir de vigilance comme des évaluations du caractère équitable des systèmes de RFA qui s’appuient sur la performance et sur les résultats des biais réels, plutôt que sur l’analyse comparative d’ensembles de données de logiciels brevetés29.

Les limites du légalisme libéral dans R(Bridges) : Une crise de l’évaluation

Il se peut que les paramètres de la légalité qui sont appliqués dans l’affaire Bridges ajustent les pratiques entourant le déploiement de la RFA d’une façon que la plupart des gens s’accorderaient à trouver préférable. Nous pouvons pourtant déjà voir qu’ils sont de peu d’utilité pour aborder la substance et l’objet de l’affaire Bridges, à savoir, le désir d’ « utiliser nos espaces publics sans être soumis à une surveillance oppressive30 ». S’appuyant sur Bridges, et contrastant en gros avec l’approche de l’AFR en temps réel de la loi de l’Union européenne sur l’intelligence artificielle,la loi britannique semble se mettre à établir et à normaliser une version invasive de cette technologie31. Dans une certaine mesure, c’est un pas de côté par rapport aux décisions d’autres cours nationales comme en France ou aux États-Unis, qui ont bien moins accepté la capture d’images en temps réel, ou qui ont exigé que soient révélées les informations techniques de fonctionnement. Pourtant, elles aussi légitiment l’utilisation de la RFA qui n’est pas en temps réel et facilitent son adoption. Cela nous conduit à nous demander si l’affaire, à travers ce cadre réglementaire, peut contraindre de façon significative les changements dans la texture de la vie politique créés par ces nouvelles technologies numériques. Pour répondre à cette question, il faut aller au-delà d’une analyse juridique. Comme nous l’avons noté dans l’introduction, certains chercheurs ont suggéré que le cadre de la proportionnalité s’est transformé en un « exercice de cases à cocher » qui empêche une discussion des conséquences normatives de cette technologie32, ou qui est entaché par un « procéduralisme » qui ne s’attarde pas sur les inquiétudes « matérielles » concernant la vie privée et la concentration de pouvoir33. Monica Zalnieriute soutient ce dernier argument, y compris dans un commentaire du premier examen de la RFA par la CEDH dans l’affaire Glukhin c Russia34, et ajoute en outre que cela normalise la RFA. Nous sommes d’accord avec cette critique, mais, comme l’affaire Bridges, elle est limitée parce qu’elle traite la transformation de l’espace public et de la vie publique par les nouvelles technologies comme un problème concernant « la vie privée des individus35 » et la façon dont le pouvoir exécutif est exercé. Ces deux catégories sont mises sous pression par l’introduction de technologies fondées sur des algorithmes comme la RFA en temps réel. Nous allons maintenant étudier la nature de ces limites dans Bridges et en tirer quelques conclusions critiques.

L’épistémologie juridique de la technologie dans l’affaire R(Bridges)

Quand on examine comment les choses sont devenues « matérielles » à l’intérieur des processus juridiques, on peut se demander « comment les juges rassemblent les informations, évaluent les revendications factuelles et jugent les personnes et les situation36 ». Pourtant, de plus en plus de chercheurs accordent une importance fondamentale à l’épistémologie juridique comme cadre pour la compréhension de la nature des processus et structures juridiques – alternative à la conception du droit en termes de pouvoir ou d’autorité37. Au-delà donc de l’identification des déséquilibres entre l’épistémologie sociale du droit et celle des technologies algorithmiques38, on doit prêter plus d’attention à l’ontologie politique des médias fondés sur les données39 et aux effets normatifs des « points aveugles » technologiques du légalisme juridique quand il traite ces médias.

Bridges démontre ces deux problèmes à travers la compréhension des images de personnes qui sont capturées par AFR Locate. La Cour reconnaît que la « RFA est une technologie novatrice40 ». Elle différencie la mise en image biométrique en temps réel des photographies analogiques et des images de vidéosurveillance de trois façons : la RFA capture plus de données qu’il n’en faut, ces données sont sensibles et réglementées par la loi sur la protection des données (DPA) de 2018, et elles sont traitées par des automates41. Voyant une analogie plus proche avec les empreintes digitales et l’ADN, la Cour distingue cependant la capacité de la RFA à capturer des données rapidement et à grande échelle sans que ceux qui en sont les sujets en aient connaissance – deux éléments de nouveauté et d’intrusivité qui sont assurément pertinents pour la transformation de l’espace public.

Il est cependant instructif de regarder comment cette nouveauté technique devient juridiquement « matérielle ». Le processus « neutralise » la nouveauté en adoptant, comme intérêt premier le degré relatif de ressemblance du cadre réglementaire à du droit. La décision dans Bridges dit que le droit de la common law et le cadre de politique de la SWP ne remplissent pas cette condition, mais, et c’est essentiel, qu’il suffirait d’ajustements mineurs pour que ce soit le cas. L’échelle et la portée nouvelle de la surveillance lors d’événements publics permis par la RFA sont donc considérées en termes d’interaction de la nouvelle collecte de données avec deux facteurs : où et qui. La dimension « publique » du où de la RFA signifie qu’elle n’est pas privée et donc partie de la pratique discrétionnaire légale de la collecte et de la conservation de données publiques. La compilation discrétionnaire des listes de surveillance est aussi autorisée par la common law et la loi sur la police et les preuves pénales (Police and Criminal Evidence Act) de 1984. Ainsi, la nouveauté de la RFA n’est juridiquement « matérielle » que dans la mesure où elle a un « effet dissuasif » sur les pratiques discrétionnaires établies de la police. Ce n’est pas que cela efface complètement la nouveauté – selon l’approche relativiste approuvée par la Cour, une mesure plus intrusive demande une régulation plus précise et plus spécifique –, mais cela veut dire qu’une nouveauté technique qui modifie l’expérience de l’espace public finit par être remédiable par des « amendements procéduraux42 » très mineurs comme l’établissement de critères pour une liste de surveillance. La neutralisation par la Cour de la nouveauté politico-technologique peut également sembler avoir des avantages – par exemple, elle a rejeté comme non pertinent pour les violations des droits le fait que AFR Locate ait eu un statut d’« essai » et ait pu être limitée plus tard43. Pourtant, le côté négatif de cette approche demeure, à savoir, la négation des effets politico-culturels généraux de la RFA – par exemple de son « effet dissuasif » sur les manifestations44 – en faveur d’une épistémologie politique du pouvoir de l’État contre les droits des individus à la vie privée et à la protection des données. Jake Goldenfein a montré comment la catégorie de la vie privée perd de sa force quand on l’applique à l’écosystème de reconnaissance faciale, et qu’elle peine à traiter de façon cohérente les images comme des données biométriques45. La confusion vient de la compréhension large que les cadres de la vie privée ont des images comme représentation de quelque chose de privé en public, alors qu’il faudrait comprendre les images de la RFA comme ce que certains chercheurs, s’appuyant sur Harun Farocki46 et sur Trevor Paglen47, ont appelé des « images opérationnelles », c’est-à-dire des images générées par et pour des processus automatisés fonctionnant à l’intérieur d’une séquence d’opérations automatisées et humaines. Ces sortes d’images entraînent leurs propres politiques48 et, comme Goldenfein le montre à travers le travail de Andrejevic et de Volcic sur la RFA dans les magasins, leurs propres effets sur les expériences de l’espace « social » à travers les systèmes qu’elles rendent possibles49.

Les intérêts de la communauté

La façon dont la technologie d’imagerie algorithmique est présentée dans les cadres juridiques de Bridges est donc absolument fondamental. Cette épistémologie facilite la vision selon laquelle on peut rendre « légale » presque toute technologie utilisée rationnellement selon un objectif déjà existant de la police en appliquant la qualité de ressemblance au droit aux pratiques entourant son utilisation50. Cela suppose que le risque prévalent qui doit être négocié aujourd’hui est l’exercice du pouvoir discrétionnaire dans l’administration et la police51, ce qui revient à affirmer que les catégories juridiques libérales sont technologiquement neutres52, et que leur enveloppe politique, avec le bon « équilibre », est capable de contenir les puissants effets d’ordonnancement politiques et sociaux des technologies algorithmiques, précisément par le tour de passe-passe consistant à séparer le nomos humain des processus de contrôle juridictionnel et la physis de la matière et de la technologie. Regardons à nouveau la rhétorique de la Cour quand elle refuse de collectiviser la mise en balance des intérêts pour le deuxième motif. Considérer l’individuel, qui a la préférence des juges, relève du « jugement », alors que considérer le nombre est dénigré comme simple « multiplication », processus mathématique dépourvu de raisonnement normatif.

L’affaire Bridges illustre les conséquences de cette vision pour tout examen des intérêts de la communauté. De tels intérêts sont juridicisés, mais aussi technicisés en étant inclus à l’intérieur des considérations juridiques de la question de savoir si l’interférence avec un droit est « en conformité avec la loi », c’est-à-dire appuyée sur une base légale, capable de protéger contre les interférences arbitraires avec les droits, effectuée selon un « objectif légitime », et « nécessaire dans une société démocratique ». Le test bien connu en quatre étapes de l’affaire Bank Mellat c Her Majesty’s Treasury (No 2)53 vérifie si l’objectif d’une mesure adoptée est « suffisamment important », lié rationnellement à l’objectif, si l’on aurait pu recourir à une mesure moins intrusive et, c’est essentiel, « si… un équilibre juste a été trouvé entre les droits de l’individu et les intérêts de la communauté ». Il existe une jurisprudence importante sur ce que cette doctrine exige des États (par exemple de justifier publiquement le déploiement de la RFA54). Le test de proportionnalité construit cependant de façon inhérente les intérêts de l’individu contre l’intérêt de la communauté. La communauté est posée comme extrinsèque et opposée aux intérêts qu’un individu peut avoir, et on la fait en outre coïncider avec les intérêts posés dans l’article 8, dont l’ « intérêt de la sécurité nationale, la sécurité publique ou le bien-être économique du pays… la prévention du trouble à l’ordre public ou des délits ». Les arguments de Bridges démontrent clairement une tentative de dépasser ces limites et d’engager une réflexion politique sur les intérêts du public et de son espace à travers ses intérêts individuels à lui. Là où Bridges essaie de plaider que les intérêts de tous les individus affectés doivent être pris en compte, la Cour souligne que « la plainte formulée par le demandeur dans cette affaire en contrôle juridictionnel est l’impact de l’utilisation de la RFA par la SWP sur lui, pas sur qui que ce soit d’autre55 », et que, comme nous l’avons noté plus haut, l’équilibre de la proportionnalité ne peut être collectivisé. De même, des arguments concernant les droits ayant une dimension collective de liberté d’association et d’expression sont en dehors du cadrage de l’affaire56. À l’inverse, la lecture que fait la Cour de l’objectif nécessaire de travail de la police est extensive, car bien que l’affaire n’ait eu à juger que les deux déploiements de RFA lors desquels Bridges était présent, les bénéfices potentiels à venir ou « anticipés » pouvaient être pris en compte57. Pourtant, en même temps, dans un contraste saisissant, la Cour refuse de suivre le raisonnement du jugement dissident du juge Lord Kerr JSC dans Beghal c Director of Public Prosecutions [2016] AC 88 sur la pertinence de tout dommage potentiel à venir58.

Aujourd’hui, on comprend l’évaluation de l’intrusion par une technologie dans une analyse de proportionnalité comme la frontière juridique clé pour contraindre la RFA. On consacre beaucoup d’énergie à classifier le niveau d’« intrusion de la vie privée » des méthodes d’analyse automatisée59, alors que certains chercheurs suggèrent qu’une législation particulière peut et devrait insérer une mise en balance « effective » des doctrines de la nécessité et de la proportionnalité60. Pourtant, Daragh Murray, qui montre l’impact « composé » sur les droits et les risques pour la « participation politique et pour le fonctionnement effectif d’une société démocratique61 », reconnaît que prendre « les effets sociétaux… en considération … ne sera pas simple62 ». Dans notre analyse, ce n’est pas seulement difficile mais empêché par les aspects fondamentaux du cadre juridique. Les limites de la conception que le libéralisme a de la communauté politique – une communauté individualiste, centrée sur le marché, obsédée par la sécurité, unitaire et statique63, etc. – sont bien connues, et nous n’allons pas les passer en revue ici, ni les limites de la jurisprudence de l’ « intérêt public64 », mais l’attention aux processus juridiques à travers lesquels une conception contingente des « intérêts de la communauté » est construite et appliquée, précisément par une rencontre avec une technologie nouvelle, est éclairante. Ces processus traduisent certaines inquiétudes à propos de l’espace public en catégories juridiques concernant la vie privée et l’intrusion de l’État. Elles calibrent et normalisent en outre l’utilisation par les pouvoirs publics des nouvelles technologies de l’information. Non seulement elles sont fondamentalement incapables d’empêcher l’utilisation de la RFA, mais elles la facilitent et la légitiment. Cela diminue l’éventail de sens politiques que les termes « légal » et « illégal » pourraient avoir, les réduisant à une catégorie technico-procédurale qui est, au mieux, secondaire par rapport à un exercice de pouvoir technologico-politique plus fondamental. Dans la mesure où la « légalité d’une affaire comme Bridges technicise donc les processus juridiques et leur capacité à faire référence aux conditions fondamentales de la vie publique, nous affirmons qu’elle a l’effet pervers de préserver la continuité du système juridique précisément en acceptant la transformation technologique de la communauté politique. Si les catégories d’un système juridique ne peuvent pas voir ou interagir avec ce qui dans une nouvelle technologie crée une perturbation politique, alors ce système a perdu le lien avec sa propre fonction d’évaluation politico-normative.

Vers un paradigme technosocial

Face à des technologies qui perturbent le sens politico-normatif de nos catégories juridiques ou y échappent, nous devons voir la conservation et le raffinement de cadres existants comme nécessaires – pour l’instant – mais pas suffisants. Cela implique de faire plus que de soutenir des conceptions existantes de la légalité comme un substitut fonctionnant pour le bien politique et normatif, comme nous le voyons si souvent aujourd’hui65. Nous devons avancer pour développer un langage normatif nouveau et politiquement significatif. Pourtant, une telle tâche semble quasiment impossible à penser. La « légalité » a été élevée au rang de valeur maîtresse, censée être dépourvue de toute valeur matérielle, afin de faciliter de façon stable les valeurs d’un monde pluraliste et désordonné66. Les cadres des droits et risques du libéralisme67, conçus en outre pour contrebalancer la « chance » de la technologie algorithmique ne sont pas seulement dominants dans les institutions68 mais également dans nos imaginations normatives, comme le montre le cadrage libéral de nouveaux droits69 et la prolifération rapide des guides d’éthique pour l’IA70 qui maintiennent le statu quo normatif71. Il pourrait être plus facile de travailler dans le sens d’une interdiction de la RFA par des processus politiques, mais la « perte de traction » (comme le dit Goldenfein) des catégories normatives fondamentales est un défi sérieux d’aujourd’hui. C’est de ces nouvelles catégories normatives dont nous avons besoin avant tout, pas seulement pour organiser des processus juridiques, mais aussi pour structurer des interventions politiques ayant du sens à propos de la technologie, comme les arguments des droits libéraux l’ont fait pour d’autres problèmes politiques dans l’histoire récente. Pourtant, aujourd’hui, l’approche dominante des chercheurs en droit et technologie reste l’idée que nous devrions concevoir une technologie et des processus qui permettent d’atteindre de façon plus adéquate les objectifs et catégories conceptuels existants de l’état de droit. Cela réaffirme la légalité libérale elle-même qui, selon nous, a besoin d’être fondamentalement remise en question. Nous pensons que nous devons prendre bien plus au sérieux l’idée que de telles catégories ne sont peut-être pas les outils les plus efficaces avec lesquels aborder le monde techno-politique qui est en train de naître et ses organisations institutionnelles.

La recherche « sociotechnique » présente une autre façon forte de penser la politique, la technologie et les conceptions institutionnalisées de la valeur, et cette approche se développe pour l’évaluation et la conception des systèmes d’IA dans un ensemble de contextes72. « Sociotechnique » veut dire, au minimum, commencer par la connaissance que « les aspects sociaux et techniques sont intimement interconnectés73 ». Dans les contextes de la police et de l’administration, cela signifie accepter trois prémisses fondamentales : d’abord, que l’action et interaction humaine est toujours médiatisée par la technologie, ensuite, que ces médiations ont des qualités politiques et éthiques inhérentes, et, enfin, que la « décision » n’est pas séparée de l’interaction humaine avec des facteurs technologiques et organisationnels, mais plutôt qu’elle leur est intrinsèque. L’analyse de l’affaire Bridges que nous avons proposée dans cet article suggère que les affaires juridiques libérales – quel que soit ce que les utilisateurs humains croient ou comprennent – a beaucoup de difficultés à atteindre ce point de départ minimal. Son épistémologie de la technologie implique une séparation inhérente de la normativité humaine et politique d’un côté et de la technologie de l’autre (ou du nomos et de la physis), ce qui permet une seconde séparation, qui lui est liée, de la légalité d’un côté et de la pluralité désordonnée des valeurs substantives de l’autre. Ces deux séparations imprègnent la pensée politique libérale en général, qui comprend la technique comme un outil ou un système neutre lequel est en principe à la fois contrôlable afin de préserver la dignité humaine et exploitable pour le « progrès » humain. Cela se manifeste aussi au niveau de la prise de décision et de la procédure, qui, comme nous l’avons vu plus haut, sont évaluées en fonction du degré de leur ressemblance avec le droit. Nous aimerions aussi souligner le rôle concret des humains-dans-la-boucle de ces systèmes, qui sont habituellement compris comme les véritables fondements ou « auteurs » d’une décision, les garants organiques, par essence non techniques et non automatisables, de la cohérence de la décision, de la responsabilité juridique et de la légitimité politique74.

Les approches sociotechniques rejettent ces séparations comme fausses ou illusoires, et s’intéressent par définition à la normativité. Elles n’ont cependant pas encore élaboré la description solide de la valeur normative au niveau politique, institutionnel et juridique que le légalisme juridique a effectuée. Pour un tel projet, un bon point de départ est le travail du philosophe français de la technologie, Gilbert Simondon, qui a montré la fausse opposition qu’il y a entre culture et technique, selon laquelle la première est le « royaume des fins » (la source et le telos de la normativité) et la seconde le « royaume des moyens » (que la culture subordonne à ses fins culturellement déterminées75). Simondon a en outre affirmé que nous ne devons pas considérer le « royaume des fins » comme fermé, « code final de valeurs » pour ce qui est de la technologie76 (ce que nous pouvons voir dans la légalité libérale). L’évolution des systèmes technologiques provoque plutôt le besoin d’une « invention normative77 » qui est existentiellement nécessaire à la vie humaine.

La tâche d’une telle invention est impressionnante, mais Bernard Stiegler, s’appuyant sur la pensée de Simondon, propose quelques balises. Il fait le diagnostic de la tradition philosophique occidentale pour ce qui est de sa fausse opposition entre ēpistēmē et tekhnē78, qui s’appuie sur la distinction que fait Aristote79 entre les être naturels qui ont la capacité de se mouvoir et les êtres techniques qui ne l’ont pas, et à qui il manque par conséquent leur propre cause finale ou telos, mais qui la trouvent dans l’humain non technique80. Le travail de Stiegler répond point par point aux trois prémisses sociotechniques fondamentales que nous avons identifiées plus haut. D’abord, Stiegler propose une description solide de la connexion intrinsèque de l’humain et de la technologie, à travers le principe de la « technicité constructive ». Comme l’explique Marco Pavanini, la vie humaine est « structurée dans son évolution et dans son développement par les médiations technologiques81 » et les humains entrent par conséquent toujours en composition avec ces dernières. Ensuite, les schèmes normatifs ne peuvent pas s’enraciner dans un humanisme non technique ou dans l’entretien d’une conception libérale correspondante de la « polis ». On doit plutôt les comprendre comme rendus possibles et réalisés par des moyens techniques, et par une réflexion sur eux, dans un milieu sociotechnique ouvert et évolutif. Le fondement de cette perspective trouve un écho dans un ensemble d’approches de recherche aujourd’hui, avec une compréhension grandissante que les valeurs sont en un sens « incarnées » dans la technologie82, que la conception peut contenir un élément fondamentalement éthique83, et que les technologies ont des « moralités matérielles » qui dépassent les intentions d’un concepteur84, ce qui rend nécessaire une réflexion sophistiquée sur l’ « assemblage » qui en résulte85. Allant plus loin, Stiegler affirme qu’une approche compositionnelle de la relation humain-technique signifie que les technologies peuvent être utilisées de façons qui sont soit curatives soit toxiques. Cette vision « pharmacologique » de la technologie donne une autre forme à la tâche normative de cette réflexion sur les humains et la technologie qui consiste à garder un milieu culturel non toxique. Un tel milieu peut impliquer d’accorder de l’importance à la dignité humaine ou à l’adhésion à la légalité, mais le recadrage des « fins » (et non pas seulement des « moyens ») de l’exercice apporte un accent différent de celui des affaires fondées sur les droits libéraux. Enfin, pour ce qui est de la prise de décision, la technologie a un rôle au-delà de celui d’être l’objet que l’on décide, ou de fournir des informations à un humain preneur de décisions. Stiegler critique le modèle du jugement de Kant dans La technique et le temps, 3, affirmant que Kant ne parvient pas à reconnaître que la possibilité du jugement est toujours fondamentalement conditionnée par le milieu technique86, depuis la façon dont il est conçu et cadré aux processus médiatiques qui le facilitent et à l’impact de ses résultats. Comme Ben Turner l’a récemment noté dans son analyse de Stiegler, les formes du jugement sont des relations transductives entre des cerveaux, des processus techniques et des systèmes sociaux87. Nous devons donc non seulement comprendre la technicité de la prise de décision, mais nous efforcer d’en cultiver des modalités curatives, plutôt que des modalités toxiques.

Si l’on trouve nombre de ces idées dans la recherche sur le droit et la technologie d’aujourd’hui, dans l’ensemble, ces approches restent fondées sur la prémisse de la priorité de la légalité, prenant certaines conceptions existantes de l’état de droit comme horizon de valeur à récupérer par une nouvelle conception et construction. Dans le débat autour de la RFA, les options semblent être encore plus limitées à soit bannir la technologie soit réglementer son utilisation par le paradigme des droits et de la légalité. Le fait que tant de principes de la pensée sociotechnique soient largement adoptés semble cependant prometteur. Grâce à un travail et une réflexion critiques soutenus – en particulier pratiques, interdisciplinaires, créatifs, collaboratifs et participatifs – il est peut-être possible de consolider la tâche d’imaginer à nouveau la valeur normative et ses formes institutionnelles au-delà des horizons de valeurs libéraux. Une simple théorisation des nouvelles conceptions de la valeur et de la « qualité » de la prise de décision ne peut pas les faire advenir, elles doivent être des aspects significatifs, répartis et partagés d’un imaginaire et d’une pratique technosociale. En tant que telle, la théorie aujourd’hui ne doit pas être tentée d’offrir des concepts de valeurs théoriques préparés à l’avance. Ce que la recherche en droit doit essayer de faire, c’est de catalyser une réflexion multi-sphères, interdisciplinaire, et multi-participative, dont le but est l’invention, le débat et la contestation normatifs et créatifs. Ce n’est qu’en travaillant collectivement à résoudre ce problème, en combinant les types de connaissances techniques, politiques, juridiques et autres, que quelque chose ressemblant à une normativité juridique ayant conscience d’être technosociale, avec des conceptions de la valeur significatives qui soient comprises comme appartenant à des technologies spécifiques mais aussi des cadres institutionnels ayant autorité pour leur évaluation, peut émerger.

Quelque distante que cette perspective puisse sembler, c’est la tâche qu’assume le projet Future of Good Decisions, financé par United Kingdom Research and Innovation (UKRI) sous la forme d’une bourse Future Leaders Fellowship (FLF) accordée au Dr Connal Parsley. La conception de ce projet de recherche reflète le besoin de travailler de multiples questions et méthodes de recherche d’une façon intégrée. Le projet commence par la philosophie contemporaine des écologies technosociales en évolution pour en tirer certaines conceptions de la valeur et de l’évaluation. Il se tourne ensuite vers la théorie juridique contemporaine des fondations et fonction du droit public, cherchant des voies potentielles de développement à la lumière de ces concepts de valeur émergents. Sur le fondement de cette théorisation, il étudie le droit et la pratique de la prise de décision administrative d’aujourd’hui et le contrôle de cette dernière par l’adoption de la technologie algorithmique. Il est important de noter que le projet adopte des méthodes participatives préfiguratives pour l’expérimentation collective et la réflexion sur la prise de décision humain-IA, faisant référence au travail de Davina Cooper et d’autres sur la recherche préfigurative en droit88. Utilisant l’adaptation des méthodes Live Action Role Play (LARP) pour interroger la technologie algorithmique en théorie politique, l’interaction humain-ordinateur, et les études de conception89, ce projet testera, suivra à la trace et reproduira les concepts de valeur dans un processus participatif, recherchant des propositions éventuelles pour une réforme de la conception de système et de la doctrine.

Conclusion

À travers une lecture critique de l’affaire Bridges, cet article a affirmé qu’intenter des actions en justice en s’appuyant sur des cadres libéraux fondés sur des droits ne permet pas de contraindre de façon significative l’utilisation de la RFA. Nous l’avons affirmé à cause des faiblesses fondamentales de l’épistémologie de la technologie de ce cadre, et de la capacité limitée du cadre de proportionnalité à l’intérieur duquel elle fonctionne de conceptualiser les « intérêts de la communauté ». Certains commentateurs ont dit que les cadres de proportionnalité risque/chance transforment la légalité en un exercice de cases à cocher, qui contourne le débat politique tout en légitimant la technologie de la RFA. Nous avons poussé cet argument plus loin, en suggérant que quand ils sont confrontés à des technologies algorithmiques comme la RFA, au lieu de fonctionner pour préserver la continuité de la communauté politique, ces cadres juridiques assument la fonction perverse de préserver la continuité du système juridique tout en facilitant la perturbation de la communauté politique. S’il reste viable de bannir la RFA, le caractère inefficace des droits libéraux et de l’éthique de l’IA signifient que nous avons toujours besoin de nouveaux critères de valeur politiques, juridiques et sociaux. Nous avons en outre montré que la perte de normativité politique effective de nos cadres juridiques est une inquiétude d’aujourd’hui pour les études juridiques, qui devraient donner la priorité à la réinvention de cadres normatifs qui interagissent de manière significative avec la technologie algorithmique. Nous avons enfin souligné les aspects pertinents des approches de recherche sociotechniques comme point de départ, en particulier le projet Future of Good Decisions90.

Article traduit par Solène Semichon

==================

NOTES

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058.[↩]

- Joe Purshouse and Liz Campbell, ‘Automated Facial Recognition and Policing: A Bridge Too Far?’, Legal Studies 42, no. 2 (2022): 211.[↩]

- Rosemary Hunter, ‘Contesting the Dominant Paradigm: Feminist Critiques of Liberal Legalism’, in The Ashgate Research Companion to Feminist Legal Theory, ed. Margaret Davies and Vanessa E Munro (Routledge, 2013).[↩]

- Scott Shapiro, Legality (Cambridge, Mass: Harvard University Press, 2011).[↩]

- Anton-Hermann Chroust, ‘Law: Reason, Legalism, and the Judicial Process’, Ethics 74, no. 1 (octobre 1963): 1–18.[↩]

- Mark D. Walters, ‘Legal Humanism and Law-as-Integrity’, The Cambridge Law Journal 67, no. 2 (2008): 357–59.[↩]

- Hunter, ‘Contesting the Dominant Paradigm: Feminist Critiques of Liberal Legalism’.[↩]

- Voir Scott Veitch, Emilios Christodoulidis, and Marco Goldoni, ‘Law and the Political’, in Jurisprudence, ed. Scott Veitch, Emilios Christodoulidis, and Marco Goldoni, 3rd ed. (Routledge, 2018); Matthew Stone, Illan Rua Wall, and Costas Douzinas, eds., New Critical Legal Thinking: Law and the Political (Milton Park, Abingdon, Oxon: Birkbeck Law Press/Routledge, 2012); Daniel Matthews and Tara Mulqueen, eds., Being Social: Ontology, Law, Politics (Counterpress, 2015).[↩]

- Voir en particulier Mireille Hildebrandt, Smart Technologies and the End(s) of Law: Novel Entanglements of Law and Technology (Edward Elgar Publishing, 2015).[↩]

- Donald R. Kelley, The Human Measure : Social Thought in the Western Legal Tradition (Harvard University Press, 1990), 1.[↩]

- Alain Supiot, Homo Juridicus: On the Anthropological Function of the Law (London: Verso, 2007).[↩]

- Lord Sales, ‘Algorithms, Artificial Intelligence and the Law’, Judicial Review 25, no. 1 (2 janvier 2020): 46–66.[↩]

- Sun-ha Hong, ‘Criticising Surveillance and Surveillance Critique: Why Privacy and Humanism Are Necessary but Insufficient’, Surveillance & Society 15, no. 2 (2017): 187–203.[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [17].[↩]

- R(Bridges)v Chief Constable of South Wales Police [2019] EWHC 2341 (Admin).[↩]

- Civil Society Groups, ‘Live Facial Recognition Technology Should Not Be Used in Public Spaces’, dernière consultation le 18 février 2024.[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [34].[↩]

- Ibid., para. [3].[↩]

- Dan Sabbagh, ‘South Wales Police Lose Landmark Facial Recognition Case’, The Guardian, 11 août 2020.[↩]

- ‘Legal Challenge: Ed Bridges v South Wales Police’, Liberty, dernière consultation le 12 février 2024, https://www.libertyhumanrights.org.uk/issue/legal-challenge-ed-bridges-v-south-wales-police/.[↩]

- ‘Response to the Court of Appeal Judgment on the Use of Facial Recognition Technology’, dernière consultation le 18 février 2024, https://www.south-wales.police.uk/news/south-wales/news/2020/response-to-the-court-of-appeal-judgment-on-the-use-of-facial-recognition-technology/.[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [94].[↩]

- Ibid para. [143].[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [199].[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [198].[↩]

- Bernard Keenan, ‘Automatic Facial Recognition and the Intensification of Police Surveillance’, The Modern Law Review 84, no. 4 (juillet 2021).[↩]

- Voir les commentaires par le Dr Daragh Murray dans Sabbagh, ‘South Wales Police Lose Landmark Facial Recognition Case’.[↩]

- Joy Buolamwini and Timnit Gebru, ‘Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification’, Conference on Fairness, Accountability, and Transparency 81 (2018): 1–15.[↩]

- Tony Mansfield, ‘Facial Recognition Technology in Law Enforcement Equitability Study Final Report’ (National Physical Laboratory, 2023).[↩]

- Sabbagh, ‘South Wales Police Lose Landmark Facial Recognition Case’.[↩]

- Vikram Dodd, Vikram Dodd Police, and crime correspondent, ‘Police Accused over Use of Facial Recognition at King Charles’s Coronation’, The Guardian, 3 mai 2023.[↩]

- Purshouse and Campbell, ‘Automated Facial Recognition and Policing’, 223.[↩]

- Monika Zalnieriute, ‘Against Procedural Fetishism: A Call for a New Digital Constitution’, SSRN Scholarly Paper (Rochester, NY, 6 novembre 2023), https://papers.ssrn.com/abstract=4624702.[↩]

- Monika Zalnieriute, ‘Glukhin v. Russia’, SSRN Scholarly Paper (Rochester, NY, 30 octobre 2023), https://papers.ssrn.com/abstract=4627057.[↩]

- Zalnieriute, 9.[↩]

- Austin Sarat et al., ‘Complexity, Contingency, and Change in Law’s Knowledge Practices: An Introduction’, in How Law Knows, ed. Austin Sarat, Lawrence Douglas, and Martha Merrill Umphrey, The Amhert Series in Law, Jurisprudence and Social Thought (Stanford: Stanford University Press, 2007), 1.[↩]

- Mariana Valverde, ‘Theoretical and Methodological Issues in the Study of Legal Knowledge Practices’, in How Law Knows, ed. Austin Sarat, Lawrence Douglas, and Martha Merrill Umphrey, The Amhert Series in Law, Jurisprudence and Social Thought (Stanford: Stanford University Press, 2007), 83.[↩]

- Vincenzo Zeno-Zencovich, ‘Legal Epistemology in the Times of Big Data’, n.d.[↩]

- Yuk Hui, ‘The New Politics of the New Media’, in The Digitized Imagination, ed. Nalini Rajan (Routledge India, 2009).[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [86].[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [86–89].[↩]

- Purshouse and Campbell, ‘Automated Facial Recognition and Policing’, 218.[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [56–8].[↩]

- Christopher Knaus, ‘Facial Image Matching System Risks “chilling Effect” on Freedoms, Rights Groups Say’, The Guardian, 7 novembre 2018 ; Keenan, ‘Automatic Facial Recognition and the Intensification of Police Surveillance’, 11; et pour une description étendue des effets potentiellement dissuasifs de la RFA, voir Daragh Murray, ‘Police Use of Retrospective Facial Recognition Technology: A Step Change in Surveillance Capability Necessitating an Evolution of the Human Rights Law Framework’, The Modern Law Review (2023) 10–15, dernière consultation le 20 décembre 2023.[↩]

- Jake Goldenfein, ‘Privacy’s Loose Grip on Facial Recognition: Law and the Operational Image’, in The Cambridge Handbook of Facial Recognition in the Modern State (Cambridge University Press, 2024).[↩]

- Harun Farocki, ‘Phantom Images’, Public 29 (2004).[↩]

- Trevor Paglen, ‘Operational Images’, E-Flux Journal 59 (2014), https://www.e-flux.com/journal/59/61130/operational-images/.[↩]

- Jan Distelmeyer, ‘Which Operativity? On Political Aspects of Operational Images and Sounds / 06 / Rosa Mercedes / Harun Farocki Institut’, dernière consultation le 13 février 2024, https://www.harun-farocki-institut.org/en/2023/05/25/which-operativity-on-political-aspects-of-operational-images-and-sounds-2/; Lucas Introna and David Wood, ‘Picturing Algorithmic Surveillance: The Politics of Facial Recognition Systems’, Surveillance & Society 2, no. 2/3 (2002).[↩]

- Mark Andrejevic and Zala Volcic, ‘“Smart” Cameras and the Operational Enclosure’, Television & New Media 22, no. 4 (2021): 343–59.[↩]

- Voir aussi Purshouse and Campbell, ‘Automated Facial Recognition and Policing’.[↩]

- Voir le cadrage du juge Sumption dans R (Catt) v Commissioner of Police of the Metropolis [2015] UKSC 9 para. [2].[↩]

- Voir Brad A Greenberg, ‘Rethinking Technology Neutrality’, Minnesota Law Review, 207 (2016).[↩]

- [2014] AC 700 para. [74].[↩]

- Murray, ‘Police Use of Retrospective Facial Recognition Technology’, 27.[↩]

- R(Bridges) v The Chief Constable of South Wales Police [2020] EWCA Civ 1058 para. [142].[↩]

- Ibid para. [150].[↩]

- Ibid para. [135].[↩]

- Ibid para. [59–60].[↩]

- Ardi Janjeva, Muffy Calder, and Marion Oswald, ‘Privacy Intrusion and National Security in the Age of AI’ (Centre for Emerging Technology and Security, Alan Turing Institute, 2023).[↩]

- Giuseppe Mobilio, ‘Your Face Is Not New to Me – Regulating the Surveillance Power of Facial Recognition Technologies’, Internet Policy Review 12, no. 1 (31 mars 2023): 19, https://policyreview.info/articles/analysis/your-face-is-not-new-to-me; Murray, ‘Police Use of Retrospective Facial Recognition Technology’, 17–21.[↩]

- Murray, ‘Police Use of Retrospective Facial Recognition Technology’, 2.[↩]

- Murray, 30–31.[↩]

- Voir Chris Henry and Iain MacKenzie, ‘The Changing Nature of the Public Sphere’, Journal of Social and Political Philosophy 2, no. 2 (2023).[↩]

- Glendon A. Schubert, ‘“The Public Interest” in Administrative Decision-Making: Theorem, Theosophy, or Theory?’, American Political Science Review 51, no. 2 (1957): 346–68 ; Anthony Gordon, John Morison, and Dimitrios Doukos, ‘Public Interest in UK Courts ESRC End of Award Report’, 2012; Adam Tomkins, ‘The Guardianship of the Public Interest: A British Tale of Contestable Administrative Law’, 経済志林 87, no. 1,2 (2017): 149–200; McKane Andrus et al., ‘AI Development for the Public Interest: From Abstraction Traps to Sociotechnical Risks’ (arXiv, 4 février 2021), http://arxiv.org/abs/2102.04255.[↩]

- Will Bateman, ‘Algorithmic Decision-Making and Legality: Public Law Dimensions’, Australian Law Journal 94, no. 7 (2020): 520–30.[↩]

- Scott Shapiro, Legality (Cambridge, Mass: Harvard University Press, 2011), 173, (nous soulignons).[↩]

- Margot E. Kaminski, ‘Regulating the Risks of AI’, SSRN Electronic Journal, 2022, https://doi.org/10.2139/ssrn.4195066.[↩]

- ‘A Pro-Innovation Approach to AI Regulation: Government Response’, GOV.UK, dernière consultation le 13 février 2024, https://www.gov.uk/government/consultations/ai-regulation-a-pro-innovation-approach-policy-proposals/outcome/a-pro-innovation-approach-to-ai-regulation-government-response.[↩]

- Le droit à l’accès à internet, mais aussi le droit à l’oubli, article 17 du RGPD, ou le droit à la « déconnexion » : voir Simon Sharwood, ‘Australia Passes Right To Disconnect Law’, dernière consultation le 20 février 2024, https://www.theregister.com/2024/02/12/australia_right_to_disconnect_law/..[↩]

- Voir par exemple, les principes ou guides publiés au nom du Vatican (https://www.vatican.va/roman_curia/pontifical_academies/acdlife/documents/rc_pont-acd_life_doc_20202228_rome-call-for-ai-ethics_en.pdf), de Pékin (https://link.springer.com/content/pdf/10.1007/s11623-019-1183-6.pdf, de Microsoft https://blogs.microsoft.com/on-the-issues/2018/12/06/facial-recognition-its-time-for-action/), et de l’UNESCO (https://www.unesco.org/en/artificial-intelligence/recommendation-ethics#:~:text=Recommendation%20on%20the%20Ethics%20of%20Artificial%20Intelligence&text=The%20protection%20of%20human%20rights,human%20oversight%20of%20AI%20systems). [↩]

- Luke Munn, ‘The Uselessness of AI Ethics’, AI and Ethics 3, no. 3 (2023): 869–77 ; Eugenia Stamboliev and Tim Christiaens, ‘How Empty Is Trustworthy AI? A Discourse Analysis of the Ethics Guidelines of Trustworthy AI’, Critical Policy Studies, (2024), 1–18.[↩]

- David Freeman Engstrom and Amit Haim, ‘Regulating Government AI and the Challenge of Sociotechnical Design’, Annual Review of Law and Social Science 19, no. 1 (2023) ; Laura Weidinger et al., ‘Sociotechnical Safety Evaluation of Generative AI Systems’ (arXiv, 31 octobre 2023), https://doi.org/10.48550/arXiv.2310.11986; Sina Fazelpour and Maria De-Arteaga, ‘Diversity in Sociotechnical Machine Learning Systems’, Big Data & Society 9, no. 1 (2022) ; Andrus et al., ‘AI Development for the Public Interest’ (arXiv, 4 février 2021), http://arxiv.org/abs/2102.04255).[↩]

- Roel Dobbe, Thomas Krendl Gilbert, and Yonatan Mintz, ‘Hard Choices in Artificial Intelligence: Addressing Normative Uncertainty through Sociotechnical Commitments’ (arXiv, 20 novembre 2019), 2, http://arxiv.org/abs/1911.09005.[↩]

- Therese Enarsson, Lena Enqvist, and Markus Naarttijärvi, ‘Approaching the Human in the Loop – Legal Perspectives on Hybrid Human/Algorithmic Decision-Making in Three Contexts’, Information & Communications Technology Law 31, no. 1 (2022): 123–53 ; Connal Parsley, ‘Automating Authority: The Human and Automation in Legal Discourse on the Meaningful Human Control of Lethal Autonomous Weapons Systems’, in Routledge Handbook of International Law and the Humanities (Routledge, 2021); Meg Leta Jones, ‘The Right to a Human in the Loop: Political Constructions of Computer Automation and Personhood’, Social Studies of Science 47, no. 2 (2017): 216–39.[↩]

- Gilbert Simondon, ‘Culture and Technics’, trans. Olivia Lucca Fraser, Radical Philosophy, no. 189 (2015): 17–23.[↩]

- Ibid, 21.[↩]

- Gilbert Simondon, Imagination et Invention (1965-1966) (Editions de la Transparence, 2008), 158, https://www.puf.com/imagination-et-invention-1965-1966?v=21813.[↩]

- Bernard Stiegler, Technics and Time, 1: The Fault of Epimetheus, trans. Richard Beardsworth and George Collins (Stanford, California: Stanford University Press, 1998).[↩]

- Aristotle, Physics, Book 2, §1: 329f[↩]

- Stiegler, 1998, p. 8.[↩]

- Marco Pavanini, ‘Multistability and Derrida’s Différance: Investigating the Relations Between Postphenomenology and Stiegler’s General Organology’, Philosophy & Technology 35, no. 1 (2022): 8.[↩]

- Mary Flanagan, Daniel C. Howe, and Helen Nissenbaum, ‘Embodying Values in Technology: Theory and Practice’, in Information Technology and Moral Philosophy, ed. Jeroen van den Hoven and John Weckert, Cambridge Studies in Philosophy and Public Policy (Cambridge: Cambridge University Press, 2008), 322–53.[↩]

- Ibo Van De Poel, ‘Conflicting Values in Design for Values’, in Handbook of Ethics, Values, and Technological Design, ed. Jeroen Van Den Hoven, Pieter E. Vermaas, and Ibo Van De Poel (Dordrecht: Springer Netherlands, 2014), 1–23.[↩]

- Peter-Paul Verbeek, What Things Do: Philosophical Reflections on Technology, Agency, and Design (Penn State University Press, 2005), https://doi.org/10.1515/9780271033228; Peter-Paul Verbeek, ‘Materializing Morality: Design Ethics and Technological Mediation’, Science, Technology, & Human Values 31, no. 3 (2006): 361–80.[↩]

- N. Katherine Hayles, ‘Ethics for Cognitive Assemblages: Who’s in Charge Here?’, in Palgrave Handbook of Critical Posthumanism, ed. Stefan Herbrechter et al. (Cham: Springer International Publishing, 2022), 1–29.[↩]

- Bernard Stiegler, Technics and Time, 3: Cinematic Time and the Question of Malaise, trans. Stephen Francis Barker, Meridian, Crossing Aesthetics (Stanford, Calif: Stanford University Press, 2011), pp. 38-54, pp. 140-146.[↩]

- Ben Turner, Returning to Judgment: Bernard Stiegler and Continental Political Theory (State University of New York Press, 2023), p. 132.[↩]

- Davina Cooper, ‘Prefigurative Law Reform: Creating a New Research Methodology of Radical Change’, Social Politics and Stuff (blog), 28 février 2023, https://davinascooper.wordpress.com/2023/02/28/prefigurative-law-reform-creating-a-new-research-methodology-of-radical-change/; Amelia Thorpe and Bronwen Morgan, ‘Prefigurative Legality: Transforming Municipal Jurisdiction’, Urban Studies Vol 60, issue 11 (2022).[↩]

- Sara Heitlinger et al., ‘Algorithmic Food Justice: Co-Designing More-than-Human Blockchain Futures for the Food Commons’, in Proceedings of the 2021 CHI Conference on Human Factors in Computing Systems (CHI ‘21: CHI Conference on Human Factors in Computing Systems, Yokohama Japan: ACM, 2021), 1–17 ; Kruakae Pothong et al., ‘Deliberating Data-Driven Societies Through Live Action Role Play’, in Designing Interactive Systems Conference 2021 (DIS ‘21: Designing Interactive Systems Conference 2021, Virtual Event USA: ACM, 2021), 1726–38.[↩]

- Ce travail a été soutenu par une bourse UKRI Future Leaders, numéro MR/W012014/1. Il a aussi été en partie réalisé lors d’un séjour au Simons Institute for the Theory of Computing, University of California, Berkeley.[↩]