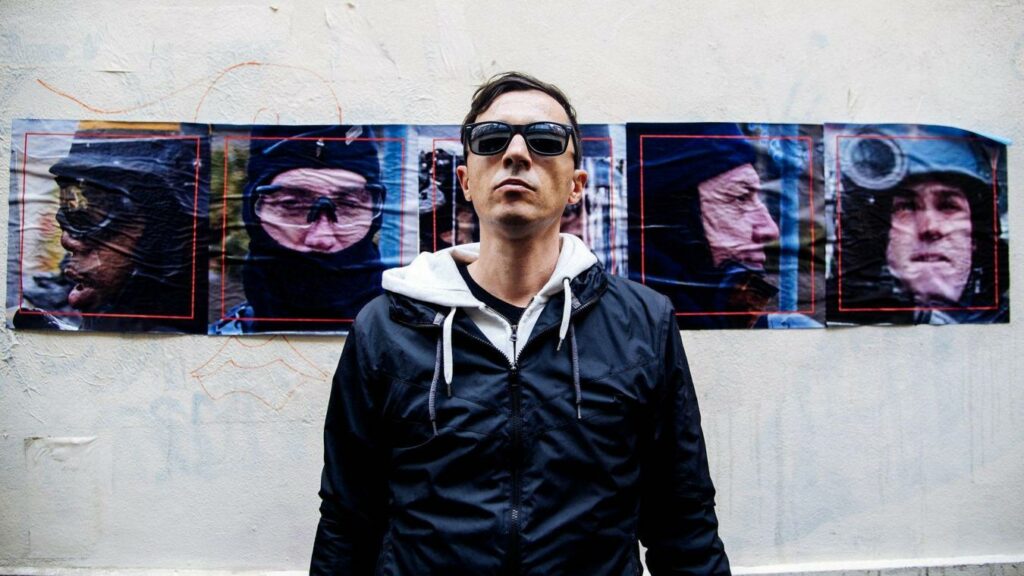

Artiste conceptuel, hacktiviste et critique culturel, Paulo Cirio incarne les principes éthiques associés aux hackeurs, promouvant le libre accès, la vie privée et l’examen critique des cadres économiques, juridiques et politiques. Il s’entretient avec Critina Voto. La traduction est de Solène Semichon.

Le 23 mars 2023, l’Assemblée nationale française a adopté une loi autorisant la vidéosurveillance algorithmique pendant les Jeux olympiques et paralympiques de 20241. Marquant un tournant significatif dans la Communauté européenne, la loi sanctionne le déploiement de systèmes de surveillance fondés sur les algorithmes pendant les événements sportifs, les concerts et les festivals présentant des risques élevés d’atteinte à la sécurité ou de terrorisme. En vertu de cette loi, les données collectées par des systèmes de vidéosurveillance pendant les Jeux peuvent subir un traitement algorithmique jusqu’au 31 mars 2026 afin d’assurer la sécurité des événements sportifs, de loisirs ou culturels particulièrement susceptibles d’être visés par des menaces de terrorisme ou des menaces sérieuses contre la sécurité des personnes à cause de leur ampleur ou des circonstances. Ce traitement par IA a pour objectif d’identifier des événements prédéfinis en temps réel qui pourraient indiquer de tels risques et d’en avertir rapidement les autorités. Une inquiétude importante se manifeste cependant : malgré la présentation de la loi sur les Jeux comme exigeante sur un plan éthique, l’accent mis sur l’exclusion des logiciels de reconnaissance faciale et, par conséquent, des données biométriques, la mise en œuvre de cette vidéosurveillance par IA présente encore des problèmes. Au-delà des déclarations rhétoriques, ces technologies émergentes posent des défis technologiques : qu’est-ce qui sera surveillé par cette nouvelle technologie ? Malgré des réglementations contre les logiciels de reconnaissance faciale, certaines inquiétudes existent sur la nature discriminatoire de la surveillance par algorithme à cause de son taux de prédiction et son impact potentiel sur les communautés vulnérables.

Ce système de surveillance automatisé est conçu pour identifier certaines anomalies comme des bagages abandonnés ou un comportement inhabituel, et pour alerter le personnel de sécurité quand il y a détection d’un « événement suspect ». Cette avancée suscite néanmoins des inquiétudes sur les conséquences potentiellement discriminantes de la vidéosurveillance par algorithme, qui touche particulièrement des groupes marginalisés comme les individus avec des handicaps, les communautés désavantagées, ou ceux qui vivent dans la rue, et dont les schémas de comportement peuvent être interprétés comme déviant de la norme. Cette législation manque de clarté concernant le comportement suspect et la définition du traitement des données personnelles reste ambiguë. Si les logiciels de reconnaissance faciale sont explicitement interdits, des inquiétudes persistent sur ceux qui analysent la foule à cause de leurs fonctions d’analogie. Des questions se posent : comment des modèles automatisés peuvent-ils effectivement représenter un comportement suspect pour prévoir des risques ? Comment la technologie passe-t-elle de l’identification faciale à la prédiction comportementale, et comment ce passage est-il incorporé dans sa conception ? Ces questions soulignent la nécessité d’un examen approfondi et d’une réglementation transparente des technologies de surveillance émergentes afin de garantir qu’elles soient éthiquement saines et de protéger les droits individuels et la vie privée.

Afin de répondre à ces défis et d’explorer les implications de ce changement de paradigme apporté par l’intégration des nouvelles technologies dans la surveillance de la foule, un effort collaboratif a été initié par l’équipe interdisciplinaire de Law and Humanities de l’université Paris-Panthéon-Assas en partenariat avec le groupe de recherche ETHICS de l’université catholique de Lille et le projet FACETS – Face Aesthetics in Contemporary E-Technological Societies – de l’université de Turin, subventionné par le Conseil européen de la recherche. Cette initiative a culminé dans l’organisation du colloque « Visages dans la foule : reconnaissance faciale, surveillance et événements publics » (« Faces in the Crowd: Facial Recognition Technologies and Monitoring Crowds at Public Events »).

Ce colloque, qui a eu lieu les 7 et 8 décembre 2023 à l’université Paris-Panthéon-Assas, a attiré des invités distingués dont l’artiste bien connu, Paulo Cirio. Renommé pour ses rôles en tant qu’artiste conceptuel, hacktiviste et critique culturel, P. Cirio incarne les principes éthiques associés aux hackeurs, promouvant le libre accès, la vie privée et l’examen critique des cadres économiques, juridiques et politiques. Il a aussi travaillé sur de nombreux projets et campagnes sur les abus de la technologie de surveillance et sa réglementation. Cristina Voto, chercheuse post-doctorante affiliée au projet ERC FACETS, a réalisé une entrevue très instructive de P. Cirio. Un dialogue et une pratique artistique interdisciplinaires permettent de promouvoir des formes plus inclusives d’expression et de lien de la communauté.

Les images et données numériques sont les matériaux premiers de votre pratique artistique. Quand vous pensez au contexte historique et culturel qui entoure votre travail, percevez-vous un changement des frontières entre les sphères publiques et privées, dû à la numérisation croissante de nos vies au nom de la sécurité publique ?

Tout d’abord, j’aimerais commencer par dire clairement que j’essaie de différencier la vie privée et la surveillance quand je travaille sur ces sujets. La surveillance se concentre sur les masses, tandis que la vie privée est un aspect plus personnel, généralement associé à des affaires privées. Ensuite, je crois qu’il est important de se rappeler que les réflexions sur les problèmes critiques liés à la surveillance étaient déjà dominantes avant 2001, en particulier dans les domaines du militantisme et des communautés de hackeurs. J’ai commencé à explorer ce thème à la fin des années 1990, dans le contexte des premières réflexions sur l’activisme en ligne, en particulier en me plongeant dans l’étude de PGP (Pretty Good Privacy), ensemble de logiciels de cryptage conçus à des fins d’authentification et de protection de la vie privée, essentiels pour la protection contre la surveillance en ligne.

Un autre facteur qu’il faut prendre en compte pendant cette période est que la majeure partie du trafic sur les sites internet permettait de voir les historiques des consultations de sites, ou au moins qu’on pouvait supposer qu’à peu près 70% des sites à cette époque n’utilisaient aucune forme de cryptage. Cela facilitait grandement la surveillance en ligne et la rendait poreuse, comme l’ont montré les révélations d’Edward Snowden2. Un rappel de ces faits nous donne un contexte culturel : à cette époque, personne ne semblait se soucier de cette situation, et, techniquement, aucune technologie n’était conçue dans ce but. Cela donne une idée claire de la surveillance de masse par la technologie qui, jusque-là, n’était pas considérée comme un problème.

Je me rappelle en outre très bien quand, avec les premières plateformes de réseaux sociaux, internet a commencé à se remplir d’images. Ce fut un vrai choc pour ceux qui travaillaient avec internet, parce qu’au départ ce dernier était principalement un média textuel. C’est fondamental parce que ce n’est que quand un média devient de masse qu’il peut vraiment transformer la société. Je me rappelle que c’est principalement Facebook qui a changé internet en le faisant passer d’un média de niche à un média non seulement pour les masses mais en particulier pour les images personnelles. Ça a été un choc particulièrement significatif pour moi de voir internet se peupler rapidement de nombreuses images individuelles et familiales montrant des situations privées. Même dans le monde du militantisme, Facebook a complètement transformé la façon dont celui-ci opère et existe. En 2004 et 2005, alors que je participais à des actions collectives contre la mondialisation pendant la période de l’après G8 à Gênes, je vivais dans un squat à Londres. Je me rappelle que nous devions trouver des façons de rendre anonyme notre présence pour organiser des actions ou avoir une carte des autres collectifs. Puis Facebook est arrivé, et il a complètement changé le paradigme et notre façon d’être liés les uns aux autres. À un moment, il est devenu essentiel d’être visible afin d’atteindre plus de personnes et de faciliter les réunions. Ça a été une période très fertile et stimulante pour moi : une nouvelle frontière s’avançait rapidement vers nous, et dans ce nouveau monde de la frontière, on pouvait faire des expériences avec beaucoup de choses, même d’un point de vue esthétique.

En 2012, j’ai créé un projet intitulé Google Street Ghost, qui est lié de près aux nouveautés introduites par l’expansion de Facebook. Dans ce projet, j’ai réfléchi au changement de perception entre public et privé dans les réseaux sociaux du début. Cet exercice était simple mais il a eu un impact : j’ai utilisé des images trouvées sur Google Street View, qui étaient déjà publiques, et je les relocalisées dans les endroits d’où elles venaient, en matérialisant ces images et en leur rendant leur dimension publique. Malgré le fait que cela ait été un projet facile, il est rapidement devenu viral, et il a eu une résonance au niveau mondial pendant des années. Il est peut-être moins visible maintenant, mais il garde assurément un certain charme. Aujourd’hui, les gens pourraient aussi le percevoir comme scandaleux à cause de la conscience que tout le monde a des problèmes de vie privée, mais à cette époque-là, voir l’une de ses images volées sur internet, imprimée et placée dans un lieu public était une idée puissante et provocatrice.

Il y a un autre projet, Persecuting US, de 2012. À cette époque-là, Twitter était au sommet de sa popularité, mais plus que de popularité nous devrions parler de nouveauté. C’était surtout la première année où il a été utilisé pendant les élections présidentielles pour de la propagande et la promotion d’idées politiques. J’ai extrait un million de profils Twitter en utilisant des hashtags particuliers liés aux débats entre Barack Obama et Mitt Romney. En utilisant des algorithmes d’exploration de données, j’ai déterminé l’affiliation politique de ces utilisateurs, en créant de la sorte une énorme base de données. À cette époque-là, l’idée que les réseaux sociaux pouvaient avoir des algorithmes capables de manipuler les flux et de filtrer ce qu’il y avait à voir n’était pas claire. On pouvait seulement acheter des hashtags, même si l’étendue réelle de cet achat n’était pas évidente. Ce projet représentait déjà une intuition de la façon dont ces outils seraient utilisés pour manipuler les sondages suivants, mais il ne s’agissait pas seulement de manipulation, cela concernait aussi la persécution, et le problème émergent était celui de la polarisation, que je voyais alors presque comme une sorte de guerre civile. Une attaque dans l’espace numérique des réseaux sociaux pouvait être encouragée en polarisant politiquement les masses. Cela semble trivial aujourd’hui, mais, à cette époque-là, la polarisation n’avait pas encore atteint son niveau actuel. Sur le site du projet, il y avait même une fonction qui permettait d’envoyer des menaces à un militant démocrate ou républicain, une provocation à démontrer comment les réseaux sociaux pouvaient devenir non seulement des outils de polarisation mais aussi d’agression.

Les deux projets reflètent le contexte historique de cette époque-là, et placent la réflexion sur la surveillance, la vie privée et la manipulation par les réseaux sociaux au centre. Il est en outre essentiel de noter que l’on ne discutait pas d’éthique à ce moment-là. C’est un aspect historique pertinent parce qu’il n’y avait pas de débat sur l’éthique de la conception d’un algorithme. C’était une sorte d’Ouest sauvage, où les entreprises d’internet pouvaient tout faire, et les utilisateurs ne posaient pas trop de questions sur la façon dont ces outils étaient utilisés. C’était l’Ouest sauvage dans le sens d’une nouvelle frontière, où je pouvais réaliser ces projets qui seraient inacceptables aujourd’hui, à la fois pour les conservateurs de musées, les musées eux-mêmes et pour le public qui les trouveraient discutables, et à juste titre.

Avec ces projets, j’avais déjà commencé à étudier les problèmes qui continueraient à m’intéresser et à m’accompagner tout au long des années suivantes. J’ai aussi commencé à enquêter sur la reconnaissance faciale, en l’utilisant pour le projet Face to Facebook en 2012, qui était un peu en avance sur ce développement technologique. À cette époque-là, la conscience sociale, culturelle et scientifique de ces problèmes était limitée. Les centres de recherche n’avaient accès qu’à un ou deux algorithmes de détection des expressions faciales, et nous n’aurions jamais pu imaginer une application pratique de cette technologie ou son développement actuel. L’utilisation de Facebook, de Twitter et même de Google représentait des opportunités formidables, et fertiles d’un point de vue artistique parce qu’elles me permettaient de mener des opérations de renseignement réel en accès libre, une sorte d’approche d’enquête s’appuyant sur des informations en ligne mais avec des outils spécifiques offerts par les réseaux sociaux. Je répète cependant que les questions d’éthique n’avaient pas encore été abordées dans ce contexte. Pendant ces années, le débat et les formes d’éthique étaient encore en train de se développer autour de l’utilisation bonne et mauvaise d’internet.

De mon point de vue, vos projets artistiques incarnent avec constance l’évolutivité et la dimension performative des données. À cet égard, nous pouvons voir comment, dans vos œuvres, la trajectoire de la technologie passe de l’individu à une échelle de masse, tout en étudiant l’impact profond de la matérialité numérique. Votre pratique artistique – qui tisse des éléments de vos expériences passées comme celle des squats à vos rôles présents, en particulier l’enseignement universitaire – suggère que vous vous consacrez à lier le potentiel actif de ces matériaux pour arriver à des résultats à fort impact. Je souhaiterais que nous approfondissions cette dimension davantage, en particulier en nous concentrant sur les images et les données. Pourriez-vous nous dire la façon dont vous négocier et dont vous abordez les entrelacs de l’évolutivité et de la dimension performative dans votre pratique artistique ?

Adolescent, je passais mes nuits à lire des livres sur le situationnisme et les cyberpunks dans les squats de Turin en Italie. Je connaissais le potentiel de l’art et des actions artistiques, et c’est ce qui m’intéressait le plus. J’ai vécu un moment important de prise de conscience quand j’ai commencé à lire les premiers livres sur le codage et les bases de données. Ça a été une révélation créative pour moi de voir la base de données comme un outil futur de l’art. Cette conscience s’est développée quand j’avais 17-18 ans. Je me suis consacré à l’étude de l’utilisation des mégadonnées, en anticipant l’ère de celles-ci, et nous parlons de la période 1998-1999, quand le concept de mégadonnées n’avait pas encore pris forme. Cette approche n’était pas qu’artistique, car j’étais conscient que cela aurait un impact politique important sur ma vie et sur le paysage environnant.

J’ai passé plusieurs années à apprendre cette technique, qui est finalement devenue une compétence que je pouvais appliquer dans l’art et dans mes activités de militant. Le travail sur les bases de données a été mon fil d’Ariane, à partir de Face to Facebook, y compris pour l’œuvre Anti-NATO Day (2001-2006), site internet que j’ai conçu contre l’OTAN et que l’on peut aussi considérer comme une base de données contenant des centaines d’articles contre la guerre. Il a représenté une innovation dans le paysage des médias, car avant lui, on avait recours aux livres, à la radio ou aux vidéos. Quand j’ai commencé à créer des œuvres avec les mégadonnées, comme Face to Facebook et Persecuting US, j’ai finalement pu mettre en pratique les études et les ambitions artistiques que je cultivais depuis des années. Cette expérience a été accueillie avec beaucoup d’enthousiasme, ce qui a confirmé mon intuition que cet art, avec cette immense quantité de données, représentait un territoire inexploré, un nouveau matériau, numérique, mais un matériau quand même. L’utilisation de ce matériau a eu non seulement des conséquences esthétiques qui n’avaient jamais été expérimentées, mais qui reflétaient aussi profondément la dimension sociale. À un certain moment, j’ai commencé à définir ces créations comme des « sculptures », parce que je donnais de nouvelles formes à ces données et que créais une interface qui était liée au monde naturel et au public.

Avec Face to Facebook, j’ai fait l’expérience du sommet des possibilités artistiques, en apercevant une fusion unique entre la dimension performative et la participation de masse à travers des bases de données. J’ai souvent répété que ça avait été la première fois qu’il avait été possible de réaliser une performance impliquant des centaines de milliers de personnes. Quand on regarde l’histoire de l’art et les nombreuses performances participatives, les projets expérimentaux, et l’utilisation massive de photos, on n’avait jamais atteint un public aussi étendu et varié. Même dans l’art cybernétique des années 1960-1970, avec ses performances à distance, on n’avait jamais touché un public aussi large. D’un point de vue esthétique, cette expérience a représenté une révolution complète, non seulement idéalisée mais effectivement réalisée.

Immergé dans la masse des données, j’ai pu éprouver des impressions semblables à celles des hackeurs, dans lesquelles le contrôle d’une masse de gens donne un pouvoir individuel et personnel. En même temps, cependant, la capacité à zoomer sur un individu engendrait un lien puissant, qui m’a permis d’explorer, d’une façon presque voyeuriste, mais pas seulement externe, les vies de ces gens. Si je pouvais voir sans être vu, en même temps, je me sentais impliqué dans l’existence de ces personnes, établissant une relation intime avec leurs images et leurs histoires. Dans cette dynamique, la dimension de l’échelle était fascinante, presque comme un minéral à facettes multiples. L’échelle de masse pose des questions de pouvoir et de contrôle, avec une qualité intrinsèque de ce matériau composé d’individus, de leurs vies privées, de leurs expériences et de leurs personnalités. Cette relation intime avec le matériau est donc un aspect significatif. Ici, le visage entre en ligne de compte, avec ses propriétés intrinsèques, comme un matériau esthétique particulièrement évident à l’intérieur de ces bases de données. L’image faciale crée un lien plus humain, intensifie l’intimité et la compréhension des relations.

En parlant des images faciales, j’aimerais que nous explorions les redéfinitions du genre du portrait à la lumière de différentes pratiques, y compris des avancées technologiques, en retraçant l’évolution esthétique depuis les photos d’identité jusqu’aux visages recadrés. Obscurity, l’une de vos œuvres de 2016, est un prisme puissant à travers lequel regarder le genre contemporain du portrait. Comment interprétez-vous cette dynamique dans votre pratique artistique et vos réflexions actuelles ?

Depuis qu’elles ont été inventées, les photos d’identité présentent des formes de portraits pour le contrôle et l’identification mais aussi des outils de discrimination dans la société de surveillance qui évolue depuis la Révolution française. Elles sont par conséquent utilisées comme matériau pour développer les technologies de reconnaissance faciale, influençant les algorithmes et les modèles d’intelligence artificielle. Ces algorithmes à leur tour incorporent un biais particulier orienté vers les criminels qui s’appuie sur des détails faciaux qui peuvent être utilisés pour identifier un individu. Cette dynamique, bien entendu, évolue avec le progrès des modèles d’intelligence artificielle. Pendant de nombreuses années, de tels algorithmes ont été utilisés par les autorités pour identifier et surveiller des criminels et les photos d’identité sont à l’origine de la discrimination de masse. Cela étant dit, la question personnelle se pose à propos de l’échelle individuelle par rapport à l’échelle de masse. Il est essentiel de souligner que, au-delà de la technologie et des algorithmes utilisés pour la surveillance, la prédiction ou la lecture des expressions faciales, les individus sur ces photos d’identité ont un contexte personnel, social, et économique particulier, qui contribue à générer ces images. La question se pose alors de savoir si c’est le contexte culturel ou le délit qui génère ces images. J’ai toujours été très intéressé par cette question.

Le projet Obscurity a représenté un moment pivot dans ma vie, qui m’a conduit à explorer ces problèmes en tant que militant en faveur de nouvelles politiques. Malgré son ampleur, j’ai été surpris par le fait que ce phénomène reçoive très peu d’attention. Dans ces années-là, l’art et les médias commençaient à discuter de l’incarcération de masse. De façon intéressante, jusqu’en 2015, le New York Times et d’autres médias n’ont pas accordé suffisamment d’attention à cette question des données criminelles circulant en ligne. J’ai collecté plus de dix millions de ces images, ce qui a établi un record de quantité par rapport à mes autres projets précédents de mégadonnées. Mon intérêt s’en est trouvé accru, et ma consternation aussi, car ces images tragiques sont profondément différentes d’autres projets.

Mon approche a suivi une stratégie qui m’a permis de cloner six sites internet de photos d’identité. J’ai recréé six plateformes pour traiter toutes les images, les rendre floues, et les remettre en ligne, en attendant les conséquences. Dans ce cas, mes projets me réservent souvent des surprises mais la réaction de choc a confirmé l’ampleur et la réalité du phénomène. Ce projet a généré un trafic important, accompagné de messages de personnes qui ont été profondément touchées par ce problème. Il est devenu un exemple tangible du lien intime que chacun de nous a avec les données. En écrivant à propos de leurs expériences douloureuses, ces individus ont créé un lien intime qui les a influencés et m’a aussi influencé. Je ne m’y attendais pas non plus, mais ce projet m’a donné un peu de stress post traumatique. Faisant face à ce problème tout seul, je suis devenu un point de référence pour ceux qui cherchaient un soutien. Ce projet s’est développé et a mué en une campagne, et un petit groupe d’individus, dont des journalistes, des universitaires et des militants se sont penchés sur ces problèmes. Cette communauté a continué à vivre pendant des années.

D’un point de vue esthétique, l’effet de flou a été réalisé grâce à un algorithme, qui a donné des couleurs et des formes intrigantes. Sa pertinence conceptuelle atteint cependant quelque chose de plus profond : le gradient qui obscurcit ces visages sur ces photos d’identité a pour but de protéger la vie privée des gens, tout en indiquant le risque de juger quelqu’un sur la base de ses traits visuels. L’image du visage devient presque illisible, non seulement pour un algorithme de reconnaissance faciale automatisé, mais aussi pour ce qui est de problèmes plus larges de reconnaissance, de vérification et de classification des visages.

Étant donné les technologies contemporaines de surveillance, comment percevez-vous la transformation de notre compréhension des événements à fort impact comme les événements sportifs ? Pourriez-vous développer le rôle que la technologie a dans la mise en forme de la conception et de la logistique à ces occasions ? Je trouve également intrigant que les lieux désignés pour les travailleurs des Jeux soient appelés « villages olympiques », ce qui évoque des parallèles avec le concept de village mondial. Ils semblent tous les deux émerger de systèmes de surveillance et de contrôle complexes, qui font porter la responsabilité du soin de la communauté – autrefois géré par des membres de la communauté dans le royaume numérique – par la technologie. Comment ce paysage en évolution influence-t-il vos considérations et réflexions artistiques ?

Quand on réfléchit au problème du contrôle de masse d’un point de vue historique, on se rend compte qu’un tel contrôle est constamment mis à jour sur l’époque, le contexte socio-économique et les outils disponibles. Dans ce contexte, la religion ressort comme l’un des premiers outils, sinon le seul, à avoir une pertinence élevée. Il est fascinant d’observer comment l’idée des divinités omniprésentes observant et jugeant l’humanité se développe à travers différents systèmes de croyance. Le contrôle symbolique est illustré par la présence de fausses caméras de surveillance, qui encouragent les individus, pour des raisons de sécurité, à se comporter comme s’ils étaient constamment surveillés, sous le regard d’une divinité.

Avec l’avènement de la modernité cependant, et la Révolution industrielle, le contrôle de masse a changé d’objectif, et il cible principalement les classes ouvrières. À l’ère industrielle, l’architecture, les emplois du temps et les salaires sont devenus des outils essentiels pour contrôler les ouvriers dans les villes importantes et les métropoles. Dans la seconde modernité de l’après-guerre, une transformation se produit, alors que les travailleurs deviennent des consommateurs, ce qui donne lieu à une nouvelle classe économique de masse. Le contrôle s’étend au-delà de la consommation pour englober les habitudes et les us et coutumes. Depuis la période de l’après-guerre, les habitudes et l’individualité sont devenues des formes de contrôle, construisant des identités autour de schémas et de styles de vie particuliers. Ce changement a donné lieu à une perte progressive du sens commun et de la communauté, qui a été remplacée par une vague d’individualisme.

L’évolution du contrôle de masse a pris un autre tournant avec l’apparition de la technologie qui souligne l’adaptation constante des stratégies de contrôle en réponse à la dynamique sociale et aux innovations technologiques. Il est essentiel de prendre en compte un aspect particulier : le contrôle de masse d’avant-guerre, enraciné dans des idéologies politiques majeures, comme le communisme, le nazisme et le fascisme. Ces idéologies unissaient les masses autours de chefs charismatiques et servaient d’outils pour les contrôler.

L’émergence de l’intelligence artificielle marque une nouvelle phase dans le contrôle et la formation de la masse. Les outils semblent suivre le contexte dans lequel la masse se développe, créant une incertitude à propos de la question de savoir si c’est la masse qui se forme avant les outils ou bien l’inverse. Nous sommes les témoins d’une transformation significative, influencée par le changement climatique, une nouvelle dynamique géopolitique et économique, et une dépendance naissante à l’inégalité financière, qui engendre de nouvelles dynamiques sociales comme des migrations à grande échelle. L’intelligence artificielle devient indispensable dans cette nouvelle réalité des masses, comparable au développement d’outils pour une auto-régulation. La dynamique évolue à des niveaux différents, et l’intelligence artificielle s’intègre parfaitement dans ces contextes, fonctionnant comme un système de contrôle adaptable.

La tendance est à un contrôle accru des mouvements des personnes et de leurs finances, accompagné d’une discrimination toujours plus grande. La dépendance à un contenu médiatisé et à des relations numériques est en constante augmentation, ce qui marque la fin de la nature et conduit à une catégorisation plus importante des masses. L’intelligence artificielle excelle à contrôler les individus à l’intérieur de la masse. Alors que les mécanismes précédents de contrôle ciblaient les masses collectivement par le biais des réseaux sociaux et de la reconnaissance faciale, l’intelligence artificielle fonctionne au niveau granulaire et individuel, éliminant le besoin d’une figure humaine aux commandes.

Pour conclure, le contrôle autrefois aux mains de figures comme le prêtre, l’officier de police ou l’ingénieur de Facebook, est maintenant exécutée par l’intelligence artificielle, ce qui signifie un changement important dans la façon dont nous gérons et contrôlons les masses. La figure dominante dans ce scénario devient une collection d’intelligence artificielle, pas une simple entité mais des unités d’IA innombrables qui exercent un contrôle et une manipulation détaillés. Cela représente une différence notable avec des développement à venir et que nous ne connaissons pas encore. Cependant, si nous allons dans cette direction, je crois qu’il existera certainement des façons de résister. Je ne souscris pas aux récits qui décrivent l’extinction de l’humain, car l’IA, bien qu’outil plus puissant, n’a pas l’élément humain qui est présent derrière chaque outil précieux. Ce changement va altérer le paysage de façon importante.

La perspective d’un contrôle individuel plus précis se déploie, opérant à un niveau de granularité impliquant personne après personne. Cet aspect représente une couche supplémentaire de transformation et de défi par rapport au passé.

Vos idées soulèvent un point puissant. Le paradigme de la surveillance que vous avez décrit peut potentiellement redéfinir notre relation aux données. Ce ne sont plus de simples éléments qui ont de la valeur seulement pour leur apparence extérieure, comme de capturer un moment particulier. À la place, tout transforme les données à travers une série de logiques prédictives. Par conséquent, l’humanité et la perspective humaine perdent leur position centrale, rendant le concept de panoptique non pertinent. En termes foucaldiens, cette structure qui nous situe de façon constante dans différentes formes de délégation – que ce soit d’un ingénieur de Facebook à un prêtre de paroisse – devient un exemple de délégation divine ou de la Silicon Valley, selon la perspective adoptée. Dans ce nouveau paysage mis en forme par la logique prédictive, enraciné dans la croyance que des formes de résistance existent toujours, un problème fondamental des données voit le jour : l’incertitude. Quand nous débattons des données et de l’établissement d’un lien archéologique adéquat allant du prêtre au système de surveillance pour les Jeux olympiques de 2024, nous devons reconnaître que l’écart est maintenant indiciel, c’est-à-dire la relation dans le contexte. Selon moi, l’absence d’un moi particulier à un moment donné crée une occasion supplémentaire de résistance, une affirmation plus large de résistance. Cette résistance est incarnée dans l’incertitude intrinsèque aux données elles-mêmes. Alors que notre perception des données change, à partir de quelque chose de spécifique, comme le suggèrent les statistiques, un monde se déploie, dans lequel l’image incertaine peut nous guider pour une réflexion sur de nouvelles perspectives. Que pensez-vous de cette perspective potentielle de résistance à l’époque des données ?

Pour ce qui est des défis contemporains de la surveillance de masse, en particulier dans les espaces publics où diverses formes de surveillance existent, le contexte entourant des événements comme les Jeux olympiques est particulièrement intrigant. D’une certaine façon, cela confirme ce dont nous sommes en train de parler. Il faut noter comment toutes ces entreprises dédiées au développement d’outils de surveillance et les pouvoirs ont récupéré notre langage, prétendant suivre des pratiques éthiques. Au même moment, cependant, ils affirment qu’ils n’utiliseront pas techniquement les données biométriques, ce qui semblait impossible il y a six mois. Maintenant, ils assurent également que les données biométriques ne seront pas utilisées. Simultanément, ils introduisent de nouvelles technologies prédictives, disant qu’elles ne sont pas aussi dangereuses que par le passé et garantissant qu’ils garderont le contrôle sur les masses grâce à ces technologies.

Mes observations montrent que ces technologies prédictives émergentes affirment leur supériorité sur les données biométriques. Si elles n’utilisent pas directement les traits du visage, elles se concentrent sur des détails comme les vêtements, la taille ou d’autres schémas de comportement. Même sans identification directe, des individus sont soumis à une surveillance accrue. Jusqu’à ce qu’un prénom ou un nom soit lié aux données, l’anonymat est préservé, mais le niveau de surveillance a augmenté par rapport aux méthodes précédentes.

Entretien traduit par Solène Semichon

==================

NOTES

- Toute l’information vient du site Algorithmic Watch, https://algorithmwatch.org/en/let-the-games-begin-frances-controversial-olympic-law-legitimizes-automated-surveillance-testing-at-sporting-events/[↩]

- Activiste et expert informatique américain. Après avoir travaillé dans la sécurité pour la National Security Agency, il a été recruté par la CIA pour travailler dans la cybersécurité. En 2013, il a été recruté par une entreprise technologique, Booz Allen Hamilton, comme consultant pour la NSA. Cette même année, S. a fait fuiter des milliers de documents classifiés de la NSA à des journalistes du Guardian qui révélaient l’existence d’un programme de renseignement de surveillance de masse mondial, et exposaient ainsi des violations de la vie privée et de la liberté d’expression et des réseaux d’espionnage. Parmi les programmes de renseignement rendus publics figurait l’interception des communications téléphoniques entre les États-Unis et l’Union européenne incluant des métadonnées des communications et le contrôle d’internet par des agences. Les États-Unis ont accusé l’expert informatique de délits comme le vol de biens de l’État américain et d’espionnage, et ont révoqué son passeport. En 2013, la Russie a accordé l’asile à S et en 2015 l’Union européenne lui a donné le statut de réfugié politique. Depuis 2016, il est le président de Freedom of the Press Foundation, une organisation à but non lucratif fondée en 2012 et soutenant la liberté d’expression et la liberté de la presse.[↩]